Das musst du über Prompt Engineering wissen

Generative KI war bisher eines der heißesten Themen des Jahres und ein Nebenprodukt davon ist, dass alle darüber sprechen, wie man sie optimal nutzen kann. Bei der Verwendung von KI-Tools sind die Ergebnisse einer einfachen Anfrage manchmal nicht das, was man erwartet hat. Es ist leicht, in diesem Fall dem Tool die Schuld zu geben, aber was ist mit der Eingabeaufforderung, mit der man begonnen hat? Könnte die verbessert werden?

Tatsächlich haben viele erkannt, dass die Optimierung von KI-Eingabeaufforderungen der beste Weg ist, um die Leistung von KI-Tools zu verbessern. Bessere Prompts = bessere Ergebnisse der KI. Und so wurde das Konzept des Prompt Engineering geboren.

Da die SERPs und Social Media Feeds weiterhin mit Content, Hot Takes und Denkanstößen über generative KI gesättigt sind, habt ihr den Begriff Prompt Engineering wahrscheinlich schon ein paar Mal gehört, und wenn es darum geht, generative KI optimal zu nutzen , ist es ein sehr wichtiges Konzept. Doch bevor ihr euch für einen Prompt-Engineering-Crashkurs anmeldet oder eine:n Prompt-Engineer anheuert, solltet ihr euch erst einmal darüber informieren, was Prompt-Engineering ist und wie es euch helfen kann, die Vorteile von KI-Content-Generatoren voll auszuschöpfen.

Was genau ist Prompt Engineering?

Prompt Engineering ist der Prozess des Erstellens, Testens und Verfeinerns von Prompts zur effektiven Nutzung von KI-Content-Generatoren und großen Sprachmodellen (LLMs).

So beeindruckend generative KI-Tools wie ChatGPT , Google Bard , Bing und Claude.ai bei der schnellen Erstellung von Content auch sein mögen, ein Nachteil ist, dass diese Tools falsche, veraltete oder irrelevante Informationen liefern können.

Im Wesentlichen ist Prompt Engineering der Prozess der Suche nach der effektivsten Kombination von Wörtern, um das gewünschte Ergebnis eines generativen KI-Tools zu erzielen. In Wirklichkeit versuchen wir alle jeden Tag, die richtige Wortkombination zu finden, um unseren Standpunkt zu vermitteln. Ihr könntet zum Beispiel die Frage stellen: „Was ist der beste Schreibtischstuhl?“, aber ohne jeglichen Kontext darüber, was ihr bei einem Schreibtischstuhl bevorzugt oder wie viel ihr bereit seid zu zahlen, wird die Person euch wahrscheinlich eine vage und subjektive Antwort geben. In diesem Fall, genau wie bei ChatGPT und anderen Tools, hilft es, genauer zu sein, um die hilfreichste Antwort zu erhalten.

Warum ist Prompt Engineering so wichtig?

Prompt Engineering ist wichtig, denn es hilft, generative KI effizienter zu nutzen und letztlich mehr aus ihr herauszuholen. Ja, generative KI hat viele manuelle Aufgaben erheblich beschleunigt, aber wie viel Zeit hat man wirklich gespart, wenn man umfangreiche Überarbeitungen oder komplette Neuformulierungen vornehmen muss, um das gewünschte Ergebnis zu erzielen?

Prompt Engineering hat auch das Potenzial, eure Contenterstellungsprozesse skalierbarer zu machen und die Konsistenz der Qualität und des Tons der Ergebnisse im Laufe der Zeit zu erhöhen. Wenn ihr einen Prompt in ChatGPT eingebt und genau das gewünschte Ergebnis erhaltet, könnt ihr den Prompt für euch selbst oder eure Teammitglieder in einer speziellen Prompt-Bibliothek speichern, um ihn in Zukunft zu verwenden.

Wie funktionieren KI-Content-Generatoren?

Im Gegensatz zu dem, was euch von Weltuntergangsprophet:innen erzählt wurde, können KI-Content-Generatoren und LLMs nicht denken. Generative KI-Tools werden von LLMs angetrieben, bei denen es sich um logische Strings handelt, nicht um vollständig empfindungsfähige Roboter, die für sich selbst denken und sprechen.

Im Wesentlichen werden LLMs mit Milliarden von Inhalten aus dem gesamten Internet gefüttert und sagen anhand ihres immensen Informationsbestands voraus, welches Wort auf ein anderes Wort folgen sollte. Wenn ihr ChatGPT zum Beispiel bittet, euch eine Geschichte zu erzählen, ist die Wahrscheinlichkeit groß, dass er mit dem Satz „Es war einmal...“ beginnt, weil die Wahrscheinlichkeit, dass eine Geschichte mit diesem Satz beginnt, aufgrund seines Inhaltsbestands hoch ist.

Das solltet ihr bei Prompt Engineering berücksichtigen

Gehen wir die Elemente durch, aus denen ein KI-Prompt besteht, sowie einige Techniken, die euch helfen, den effektivsten Prompt für jede eurer Aufgaben zu erstellen.

Elemente eines Prompts

Oberflächlich betrachtet scheint eine Eingabeaufforderung so einfach zu sein, dass man der KI sagt, was sie tun soll, sei es das Sortieren von Daten, das Erstellen von Content, das Generieren eines Bildes oder die Unterstützung bei der Recherche. Und obwohl die Bereitstellung eines Befehls eine wichtige Komponente ist, ist dies nur einer der vier Hauptaspekte, die bei der Entwicklung von Prompts zu berücksichtigen sind.

- Anweisungen

Das bezieht sich auf die Aufgabe, die der LLM erledigen soll. Sie enthält eine Beschreibung der Aufgabe, die erledigt werden muss. Je spezifischer ihr seid, desto besser sind die Ergebnisse in der Regel.

- Kontext

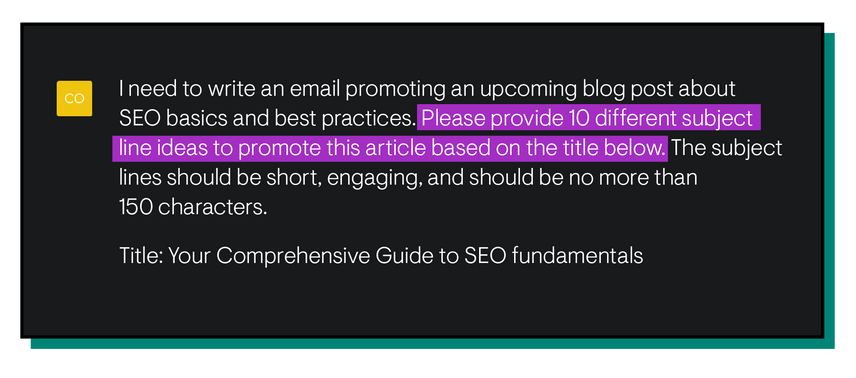

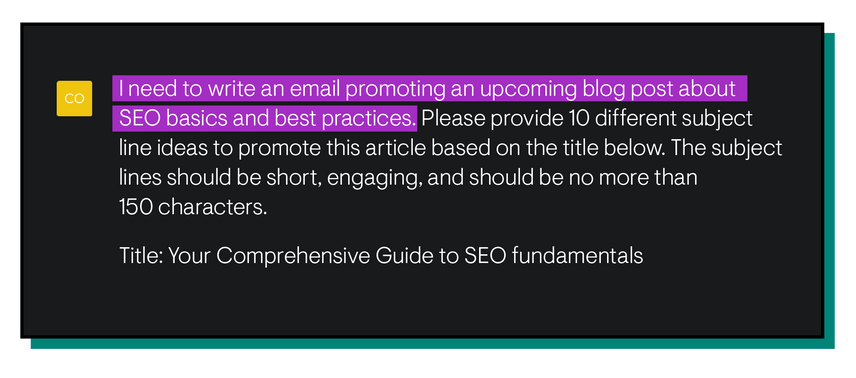

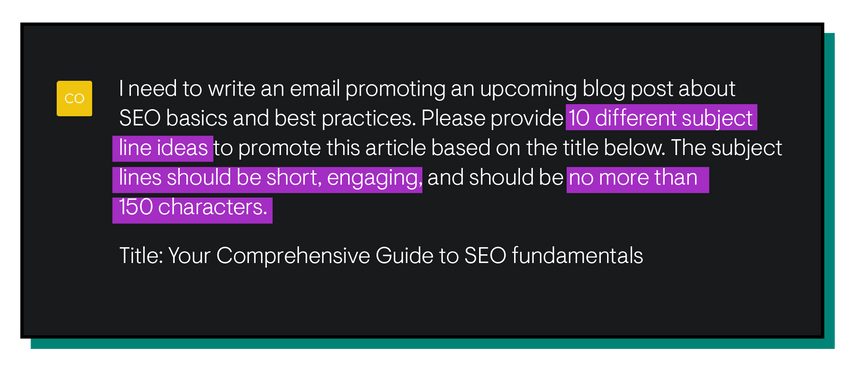

Der Kontext bezieht sich im Wesentlichen auf den Grund eurer Anfrage. Dazu können Informationen gehören wie die Zielgruppe für einen Inhalt, Details über eine größere Kampagne, zu der etwas gehört, oder sogar die Art des Formats, in dem ihr die Arbeit benötigt. Wenn ihr z. B. Hilfe beim Schreiben von Betreffzeilen für Werbe-E-Mails benötigt, wäre die Bitte um zehn Betreffzeilen eure Anweisung. Der Kontext wäre der Zweck, der Ton und die Zielgruppe der E-Mails, zusammen mit einer wichtigen Botschaft, die der E-Mail-Text vermitteln soll. All das hilft dem LLM, den Inhalt einzugrenzen, um das Ergebnis spezifischer auf eure Anfrage abzustimmen.

- Eingabedaten

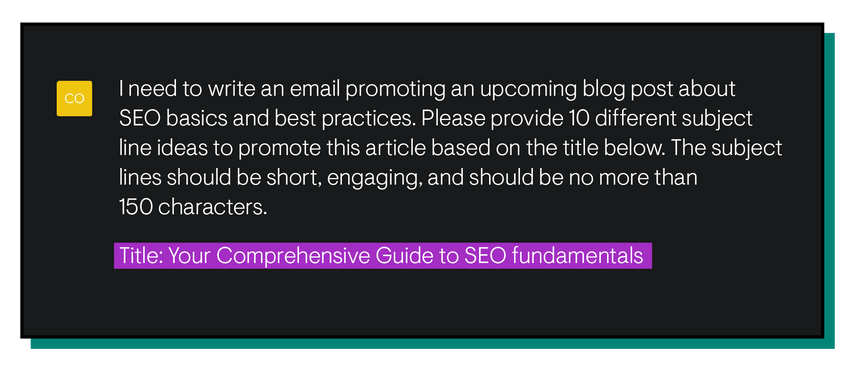

In Bezug auf den Kontext eurer Anfrage beziehen sich die Eingabedaten auf den tatsächlichen Inhalt, den ein LLM lesen und auf den er seine Arbeit direkt stützen wird. Dabei kann es sich um einen bestehenden Inhalt handeln, den ihr zusammenfassen müsst, um eine Reihe von Datenpunkten, die ihr organisieren müsst, oder einfach um Beispiele, die der KI helfen können, dem gewünschten Ergebnis näher zu kommen. Um auf unser obiges Beispiel zurückzukommen: Wenn ihr Betreffzeilen für eine Werbe-E-Mail benötigt, könnt ihr die E-Mail, die ihr versenden werdet, in ChatGPT einfügen, um den Kontext hinzuzufügen. Die Kopie der Werbe-E-Mail wäre dann eure Eingabedaten.

- Output-Indikatoren

Das ist eine schicke Umschreibung für das Format oder die Struktur, in der die Arbeit fertiggestellt werden soll. Dazu können Informationen wie eine bestimmte Wortzahl, die Anzahl der Aufzählungspunkte oder die Reihenfolge der Informationen gehören. Um noch einmal auf das Beispiel mit den Betreffzeilen zurückzukommen: Wenn ich möchte, dass die Betreffzeilen eine bestimmte Länge haben, könnte ich um maximal 150 Zeichen pro Betreffzeile bitten. Diese Anforderung wäre ein Ausgabeindikator.

Was ist eine gute Aufforderung für KI-Content-Generatoren?

Lasst uns einige konkrete Strategien zur Verbesserung des Prompt Engineerings durchgehen.

Trial and Error

Das ist das eigentliche Herzstück der Prompt-Technik. Gebt einen Prompt ein, seht, was das Ergebnis ist, ändert den Prompt und bewertet das neue Ergebnis. Beurteilen und wiederholen. Haltet es einfach, probiert es aus und seht, wohin es euch führt.

Nehmt euch auch die Zeit, mit verschiedenen KI-Tools zu spielen und die Ergebnisse der verschiedenen Modelle zu vergleichen. Google Bard könnte auf dieselbe Frage eine völlig andere Antwort geben als ChatGPT. Manchmal kann sogar ein und dasselbe LLM unterschiedliche Antworten auf dieselbe Frage geben. Probiert aus, was für jeden funktioniert, und denkt daran, eure alten Eingabeaufforderungen in einer Eingabeaufforderungsbibliothek zu speichern, während ihr arbeitet. Selbst wenn sie nicht zum gewünschten Ergebnis geführt haben, könnt ihr sie verwenden, um andere Prompts in Zukunft zu verfeinern und zu optimieren.

Problemformulierung

Das ist eine schicke Art zu sagen: Beschreibt das Problem, das ihr lösen wollt, in seiner einfachsten Form. KI-Content-Generatoren wie ChatGPT können beispielsweise die Kästchen einer Metabeschreibung gut abhaken, aber sie verstehen nicht unbedingt, warum ihr eine erstellen wollt. Zerlegt das Problem in seine einfachste Form und erklärt dann, wie KI helfen kann.

Beispiele geben

KI-Content-Generatoren, die von LLMs wie ChatGPT betrieben werden, liefern bessere Ergebnisse, wenn die Anfrage spezifischer ist. Auch bei der KI gilt, dass man das herausbekommt, was man hineinsteckt. In diesem Sinne kann es in vielen Fällen hilfreich sein, ein Beispiel für das gesuchte Ergebnis zu liefern, um dem Tool einen Anstoß in die richtige Richtung zu geben. Dazu könnte zum Beispiel der E-Mail-Text einer früheren Kampagne gehören, um dem Content-Generator eine Vorstellung von der Struktur, der Länge, dem Ton oder sogar dem Inhalt einer neuen E-Mail zu geben. Einige Tools, wie Claude.ai, ermöglichen es euch sogar, PDFs und andere Dokumente an eure Eingabeaufforderung anzuhängen, um dem Modell einen Kontext zu geben.

Prompt Priming

Beim Prompt Priming geht es im Wesentlichen darum, die Grundlage für das Verständnis eines KI-Tools für ein Thema zu schaffen. Bevor ihr zum Beispiel ChatGPT bittet, einen Text für eine P2P-E-Mail zu schreiben, solltet ihr es zunächst bitten, euch zu sagen, was eine P2P-E-Mail einzigartig macht. So könnt ihr herausfinden, was ihr erreichen wollt und wie die KI euch dabei helfen kann. Probiert es selbst aus: Bittet ChatGPT, etwas zu erstellen, und macht dann dasselbe, aber gebt zuerst euren Prompt ein und vergleicht die Unterschiede.

Prompting-Tools

Manchmal fühlt man sich von den Möglichkeiten der generativen KI überwältigt und weiß nicht, wie man mit der Frage beginnen soll. In diesem Fall hilft es, zu sehen, was bei anderen Menschen funktioniert hat. Tools wie AIPRM sammeln und kompilieren effektive Prompts von echten KI-Power-User:innen, um Content Creator:innen eine Starthilfe für ihre Prompts zu geben und ihre Prompt-Bibliothek zu erweitern.

Wirksame Techniken für Prompt Engineering

Nachdem ihr nun wisst, aus welchen Elementen sich ein Prompt zusammensetzt, wollen wir uns nun mit den verschiedenen Methoden der Promptentwicklung befassen und herausfinden, welche Techniken je nach Anforderungen am besten geeignet sind.

Zero-Shot Prompt

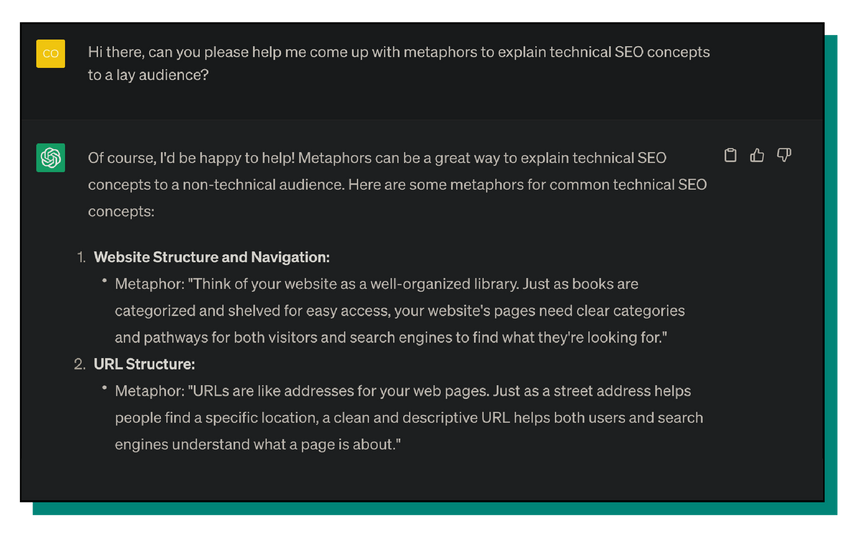

Ein Zero-Shot-Prompt bezieht sich auf einen Prompt ohne Kontext oder Eingabedaten, sondern nur auf eine Anfrage nach Informationen oder eine direkte Frage. Beim Zero-Shot-Prompting muss das LLM nur aus seinem eigenen Informationsbestand schöpfen, um die Anfrage zu beantworten. Stellt euch Zero-Shot Prompting so vor, als würdet ihr Google etwas fragen. Zum Beispiel wäre es ein Zero-Shot Prompting, ChatGPT um einige Metaphern zu bitten, um SEO-Prinzipien einem Laienpublikum zu erklären.

One-Shot Prompt

Da das Zero-Shot-Prompting dem LLM keinen Kontext oder Beispiele liefert, bietet das One-Shot-Prompting – ihr habt es erraten – ein Stück Kontext oder Beispiel. Das ist besonders effektiv, wenn das Modell ein bestimmtes Muster oder Format verstehen muss, um die Anfrage zu vervollständigen, etwa ein mathematisches Problem oder eine Gleichung. Ihr könntet einer KI beispielsweise einen Inhalt zu einem Google-Update vorgeben und sie bitten, diesen in Aufzählungspunkten zusammenzufassen.

Few-Shot Prompt

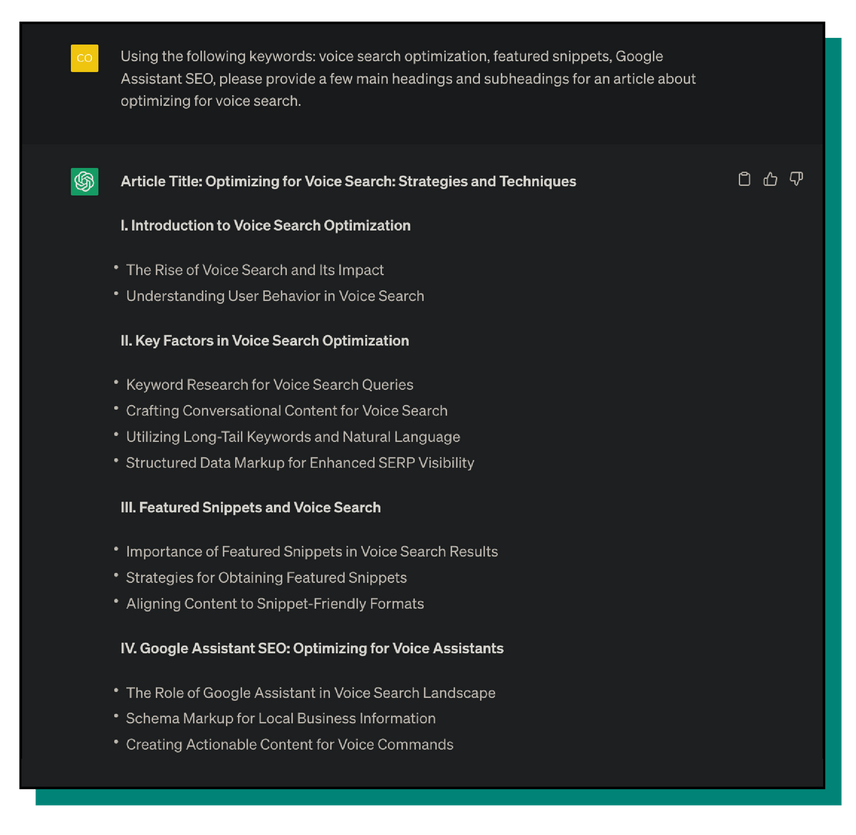

Als direkte Erweiterung des One-Shot-Prompts geben Few-Shot Prompts dem Modell mehr Kontext und Beispiele, um eine Aufgabe zu erledigen. Das ist besonders effektiv, wenn die Ergebnisse von One-Shot Prompting nicht ausreichen. Ein Beispiel für eine „few-shot prompting“ ist die Angabe von Beispielen für Keywords und Suchanfragen, für die ihr mit einem Inhalt über Sprachsuche ranken möchtet, und die Aufforderung an die KI, einige Haupt- und Unterüberschriften zu liefern.

Man bekommt von LLMs das, was man eingibt. Mehr Kontext ist in der Regel besser geeignet, um der Output auch beim Thema bleibt.

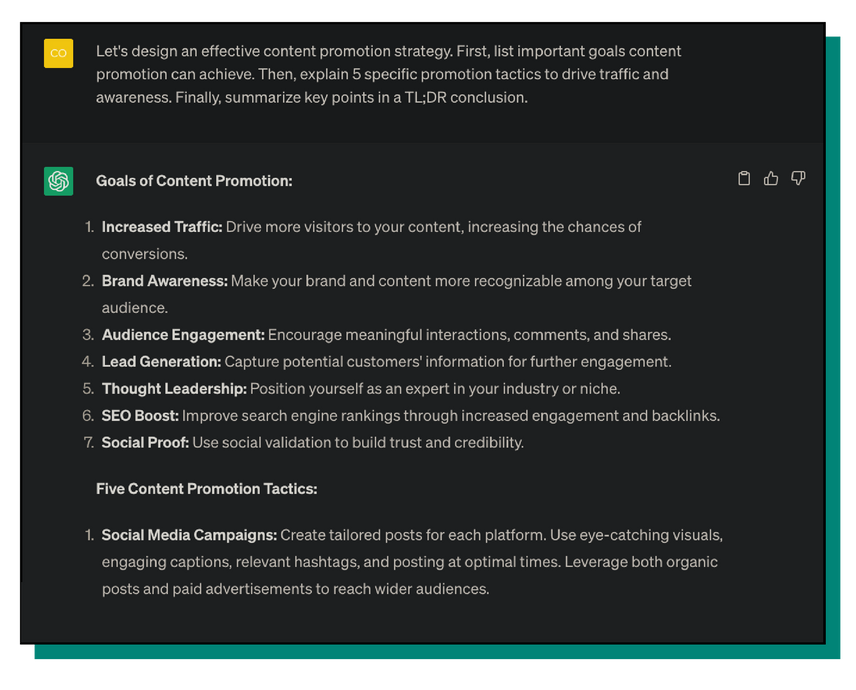

Chain-of-Thought Prompt

Die Technik der Gedankenkette bezieht sich auf eine Reihe zusammenhängender Aufforderungen, die dem Modell helfen, eine gewünschte Aufgabe in einen Kontext zu stellen. ChatGPT zum Beispiel erinnert sich nicht nur an den Kontext früherer Fragen und Antworten in einem einzigen Chat, sondern das führt auch zu besseren Ergebnissen, die wir später besprechen werden. Diese Art von KI-Prompting ist sehr effektiv für komplexe Aufgaben. Das könnte so aussehen, dass ihr durchsprecht, wie eine effektive Content-Promotion-Strategie aussieht.

AMA Prompt

AMA prompting oder Ask-me-anything ist eine Art Auswuchs des Chain-of-Thought-Prompting und bezieht sich auf einen Ansatz zur Entwicklung von Prompts, der versucht, offene Antworten des Modells zu fördern. Einfach ausgedrückt, wird beim AMA-Prompting versucht, einem LLM offene Fragen zu stellen und im Wesentlichen ein Gespräch mit ihm fortzusetzen, wobei die Prompts nach und nach verfeinert werden. Anstatt nach einem einzigen perfekten Prompt zu suchen, tendiert AMA-Prompting eher zu einer Konversation zwischen Nutzer:innen und der KI, die sich auf mehrere unvollkommene Prompts stützt, um das gewünschte Ergebnis zu erzielen. Ihr könntet zum Beispiel um eine Frage zu den Vor- und Nachteilen verschiedener Linkaufbau-Techniken bitten.

Wie verwalte ich die von mir erstellten Eingabeaufforderungen?

Um KI erfolgreich in eure digitale Strategie einzubinden, müsst ihr Prompts erstellen und diese im Laufe der Zeit verwalten, dokumentieren und optimieren. Was nützen schließlich eine Menge ausgeklügelter Prompts, wenn niemand weiß, wo sie zu finden sind?

Prompt-Bibliothek erstellen

Unabhängig davon, ob ihr in ein Tool investiert oder eine detaillierte Tabelle führt, solltet ihr die von euch erstellten Prompts, die ihr als wertvoll erachtet habt, dokumentieren. Das macht es für euch, euer Team und künftige Mitarbeitende einfacher, schnell mit der KI-Generierung fortzufahren, anstatt Zeit mit dem Experimentieren zu verbringen, um die perfekte Aufforderung zu finden.

Prompt Engineer anstellen

Ob ihr eine:n Prompt Engineer in Vollzeit einstellen müsst, hängt von der Größe eures Unternehmens, der Bandbreite und dem Budget eures Teams sowie von Dutzenden anderer Faktoren ab. Bevor ihr hier eine Entscheidung trefft, solltet ihr überlegen, wie sich KI heute in eure Strategie einfügt und wie ihr sie morgen einbinden möchtet.

Wenn KI eine wichtige Initiative ist, die euer Team vorantreibt, kann es sich lohnen, zusätzliche Mitarbeitende einzustellen, um eure Prompt-Bibliothek zu verwalten. Aber denkt daran, dass KI-Unternehmen ihre Tools ständig aktualisieren und versuchen, ein besseres Produkt auf den Markt zu bringen. Im Laufe der Zeit werden die Tools immer besser verstehen, wonach Nutzer:innen fragen, und der Bedarf an hochgradig kuratierten Prompts könnte schwinden.

Prompts laufend optimieren

Wie bei allem anderen auch, ist die Entwicklung eines Prompts nicht abgeschlossen, sobald ihr die perfekte Wortkombination auf ChatGPT gefunden habt. Zum einen kann ein Prompt, den ihr bei ChatGPT mit großem Erfolg verwendet, ein völlig anderes Ergebnis bringen, wenn ihr ihn in ein anderes Tool eingebt.

Außerdem werden die KI-Tools ständig verbessert. Diese Verbesserung erfolgt schnell. OpenAI ist bereits auf Version 4 von ChatGPT. Wer weiß, wann das nächste Update kommt. Wenn sich diese Tools verbessern, werden eure bewährten Eingabeaufforderungen möglicherweise nicht mehr das gleiche Ergebnis liefern wie zuvor.

Prompt Engineering im Überblick

Prompt Engineering ist der Schlüssel zur Maximierung eurer Nutzung generativer KI. Wenn ihr nicht genau wisst, wie ihr effektive Prompts erstellt, verschwendet ihr möglicherweise Zeit, anstatt sie zu sparen, was ja das Hauptziel der KI ist. Das Wichtigste bei der Entwicklung von Prompts ist jedoch, dass die Erstellung effektiver Prompts ein laufender Prozess ist, der sich mit der Weiterentwicklung der KI nur verändern wird. Investiert die Zeit, um mit generativer KI und euren Prompts zu experimentieren. Ihr werdet nicht wissen, was funktioniert, bis ihr es ausprobiert habt.